Депутаты Государственной Думы приступили к разработке закона по маркировке контента, сгенерированного искусственным интеллектом (ИИ), сообщает портал «Роскачество».

Сегодня обсуждение идёт относительно того, как именно и в каких случаях надо будет маркировать ИИ-контент и кто должен нести ответственность за его распространение. Ещё один обсуждаемый вопрос — маркировка должна касаться только и исключительно ИИ-контента, распространяемого тем или иным СМИ, или же маркировка должна относиться и к пользовательскому контенту, используемому как бы в личных целях.

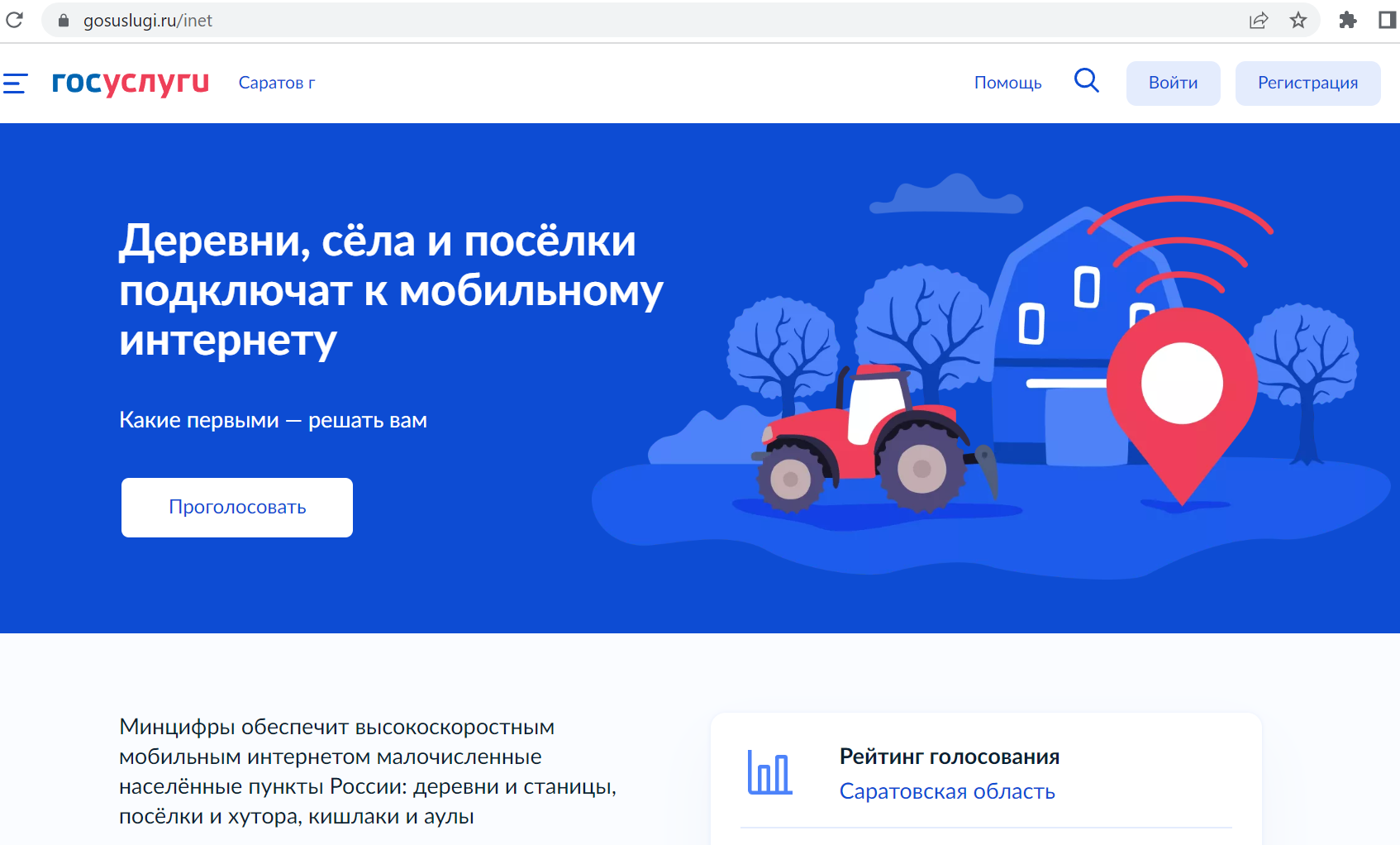

К чему может привести принятие подобного закона? Российские ИИ-сервисы будут обязаны маркировать сгенерированные ими текст и изображения (в том числе, само собой, и видео). Поэтому, уверены эксперты «Роскачества», крупным компаниям типа «Сбера» или «Яндекса» уже сейчас следует подумать о внедрении у себя технологии такой маркировки.

Эксперты отмечают, что необходимость принятия закона о маркировке контента, сгенерированного нейросетями, назрела уже давно. Опасения очень просты: неконтролируемое распространение ИИ-контента, да к тому же ещё и без обозначения того, что это есть продукт нейросетей, может привести к дезинформации и вызвать панику среди населения.

Специалисты считают, что законопроект Евросоюза об искусственном интеллекте (Al Act) является одним из самых проработанных. Он основан на градации систем ИИ по уровню потенциального риска (ожидается, что в Евросоюзе закон вступит в силу не ранее 2025 года).

Схожим путём идёт законодатели в США, особенно в части требований к разработчикам систем ИИ по прозрачности процессов. Причём, в Штатах стремятся в законопроекте повысить уровень безопасности, для чего разрабатываются подробные технические стандарты и тщательно сформулированные принципы маркировки ИИ-контента.

В Китае также разрабатывается аналогичный закон, но — более комплексного характера. Одним из основных требований в нём — обязательство провайдеров генеративного ИИ маркировать контент специальными водяными знаками. За удаление или сокрытие таких меток предусматриваются строгие санкции.

Эксперты считают, что законодательное регулирование ИИ-контента является первым шагом к формированию здоровой цифровой экосистемы. Причём, для пользователей польза будет очевидна, потому что:

- большинство людей — увы и ах! — не способны критически воспринимать огромные информационные потоки, а метки относительно ИИ помогут им легче и быстрее распознавать брехню нейросетей и избегать распространения ИИ-контента;

- водяной знак (равно как и другой способ маркировки) будет способствовать осознанному потреблению цифрового контента и снижению риска поддаться на уловки мошенников и прочих негодяев и аферистов;

- маркировка будет служить своего рода страховкой для общества и бизнеса, хотя, конечно, не могут гарантировать 100-процентную защиту от дезинформации.

СПРАВКА

В последние годы в мировой Сети отмечается стремительный рост фейков, а проще говоря — брехни, подтасовки.

По данным АНО «Диалог Регионы», в 2023 году в Рунете было зафиксировано (только зафиксировано!)_ порядка 4 тыс. уникальных контент-сообщений и порядка 12 млн. случаев их распространения. Эксперты осторожно прогнозируют, что в 2024 году их число достигнет 4,5 тыс., а количество копий вырастет до 15 млн.

Предполагается, что маркировка ИИ-контента будет осуществляться при помощи графических или водяных знаков. Метки должны выглядеть ненавязчиво, но при этом заметно.

Комментарии: